Questões de Concurso

Filtrar

226 Questões de concurso encontradas

Página 4 de 46

Questões por página:

Questões por página:

Concurso:

IF-PA

Disciplina:

Algoritmos e Estrutura de Dados

Durante o desenvolvimento de um sistema de planejamento de rotas para transporte público urbano, um professor do EBTT orientou seus alunos a analisar diferentes algoritmos clássicos de grafos com base em sua aplicabilidade e eficiência computacional. O sistema considera, além da distância, outros fatores como custo, tempo de deslocamento e subsídios tarifários, o que pode resultar em pesos negativos nas arestas do grafo. No entanto, não se admite a existência de ciclos com peso negativo, pois eles inviabilizariam o cálculo de rotas válidas. O sistema calcula as melhores rotas a partir de um ponto de origem único. Considerando esse contexto e o comportamento dos algoritmos em grafos ponderados, o melhor algoritmo para a aplicação é:

Concurso:

IF-PA

Disciplina:

Algoritmos e Estrutura de Dados

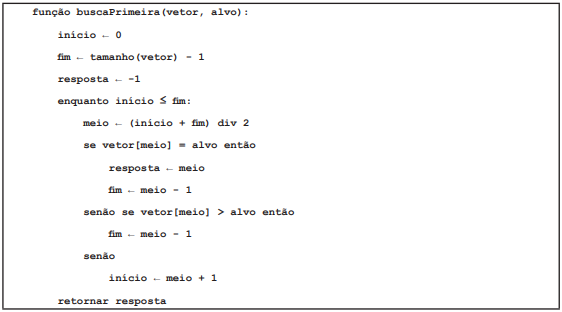

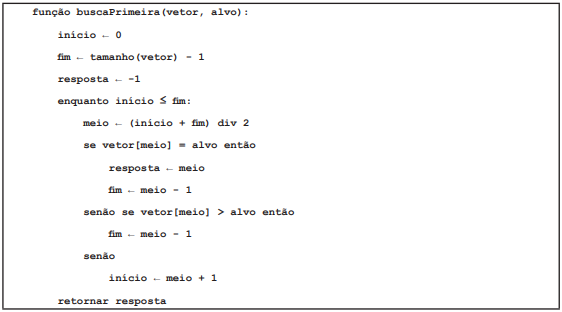

O algoritmo buscaPrimeira, apresentado a seguir, implementa uma versão modificada da busca binária, cujo objetivo é localizar a primeira ocorrência de um valor alvo em um vetor ordenado (possivelmente com valores repetidos).

Dado o vetor V = [2,4,4,4,5,7,9] e o valor alvo = 4, a execução da função buscaPrimeira(V,4) retornará:

Dado o vetor V = [2,4,4,4,5,7,9] e o valor alvo = 4, a execução da função buscaPrimeira(V,4) retornará:

Dado o vetor V = [2,4,4,4,5,7,9] e o valor alvo = 4, a execução da função buscaPrimeira(V,4) retornará:

Dado o vetor V = [2,4,4,4,5,7,9] e o valor alvo = 4, a execução da função buscaPrimeira(V,4) retornará:

Concurso:

IF-PA

Disciplina:

Algoritmos e Estrutura de Dados

Durante uma aula sobre algoritmos de ordenação, um professor propôs a análise do impacto do particionamento nos algoritmos recursivos baseados em divisão e conquista. Considerando o comportamento no pior caso, quando os dados estão previamente ordenados de forma crescente, o algoritmo que apresenta o maior número de comparações e divisões desbalanceadas, com consequente piora da complexidade assintótica, é:

Concurso:

Câmara de Mangaratiba - RJ

Disciplina:

Algoritmos e Estrutura de Dados

Observe o algoritmo a seguir.

Após a execução, será gerada a seguinte série de números:

Durante o desenvolvimento de um módulo de triagem de pacientes em um hospital público, foi necessário implementar um algoritmo para ordenar rapidamente uma lista de prioridades de atendimento, com base em tempo de chegada e gravidade do caso. Assinale a alternativa CORRETA que corresponde ao algoritmo eficiente para listas grandes, quando se busca desempenho e complexidade média ideal.